Politica e società

L’illusione dell’imparzialità: come i bias influenzano l’IA

Perché non possiamo aspettarci degli algoritmi super partes?

A cura di

Alessandra Vailati

Immagini di

Kate Crawford, Trevor Paglen

☝🏻 Abbonati a Ratpark Magazine

☝🏻 Condividi se ti è piaciuto!

Sempre più spesso, nella nostra vita quotidiana, abbiamo a che fare con l’intelligenza artificiale (IA): in maniera più evidente quando ci rivolgiamo a ChatGPT, meno quando utilizziamo motori di ricerca come Google, oppure navighiamo sui social. Siamo abituati ad immaginare l’IA come una sorta di genio della lampada, che consultiamo al bisogno per fornirci la risposta ai nostri desideri, simile a un’entità onnisciente e onnipotente, pronta a soddisfare ogni nostra richiesta. Tuttavia, questa narrazione, per quanto affascinante, è ben lontana dalla realtà.

Il capitale umano dietro l’IA

Sul finire degli anni ’70, Lewis Mumford iniziò a parlare di megamacchina per descrivere come ogni sistema, indipendentemente dalle sue dimensioni, sia realizzato grazie alla forza lavoro umana. Anche l’IA impara ad etichettare i contenuti grazie ai crowdworkers, che guidano l’algoritmo verso il risultato corretto, o identificano e bloccano contenuti violenti. Questi lavoratori sono sottoposti a lunghe giornate di lavoro, fino a 14 ore al giorno, spesso senza formazione specifica e per un salario molto modesto, soprattutto considerando che l’esposizione quotidiana a contenuti violenti può avere effetti nocivi sulla loro salute mentale.

Esempio emblematico è il caso di ImageNet, uno dei dataset più rilevanti quando si parla di addestramento dell’IA. Fondato nel 2006 dalla professoressa Fei-Fei Lin, si proponeva di costruire un’ontologia delle immagini assumendo studenti universitari a 10 dollari l’ora.

La scarsità del budget non avrebbe permesso però di classificare un gran numero di dati nei tempi desiderati, e quindi ImageNet si è affidato ad Amazon Mechanical Turk, una piattaforma di crowdsourcing che consente ad aziende e sviluppatori di esternalizzare compiti che richiedono l’intervento umano, pagando pochi centesimi attività come etichettatura di immagini, trascrizioni di testi, o moderazioni di contenuti.

L’Organizzazione internazionale del lavoro (OIL) delle Nazioni Unite ha intervistati 3500 crowdworkers che partecipavano attivamente a varie piattaforme simili a quella creata da Amazon, come Figure Eight, Microworkers e Clickworkers, notando come queste persone, seppur con un alto livello di istruzione, avessero una paga inferiore rispetto al salario minimo locale.

Come impara un algoritmo

Una volta chiarito il ruolo nascosto del lavoro umano, è utile comprendere il funzionamento degli algoritmi. Per addestrare un algoritmo, ad esempio per riconoscere qualcosa in un’immagine come un volto o un oggetto, il primo passo è raccogliere una grande quantità di informazioni, in questo caso immagini. Queste immagini costituiranno la base fondamentale da cui la macchina potrà apprendere, e sono chiamate ground truth. In quello che viene chiamato percorso di apprendimento supervisionato automatico, gli ingegneri devono fornire alla macchina nuovi dati di addestramento, ma questa volta etichettati.

Successivamente, gli algoritmi detti learner e classifier lavorano insieme su diversi livelli per perseguire lo stesso obiettivo: l’algoritmo learner viene addestrato su questo specifico set di dati etichettati e, una volta formato, è in grado di istruire l’algoritmo classifier su come analizzare nuovi input e fornire l’output corretto.

Il set di dati fornito è cruciale per ottenere un risultato efficace nell’apprendimento automatico, ma questo sistema ha anche delle criticità. Se, ad esempio, durante l’addestramento di una macchina al riconoscimento delle mele venissero fornite solo immagini di mele verdi, quelle rosse non verrebbero riconosciute come tali: questo fenomeno è noto come interferenza induttiva.

L’importanza cruciale di questi set di dati nel determinare il modo in cui gli algoritmi vedono il mondo spinge i ricercatori a confrontarli costantemente per individuare quali siano i più efficaci e come evolvano nel tempo, condividendo inoltre i risultati con la comunità scientifica, e questo ha portato allo sviluppo di una sorta di linguaggio comune tra dati di addestramento e algoritmi. Quando un set di dati di addestramento viene riconosciuto come standard, di solito viene modificato e ampliato in base alle esigenze dei ricercatori, creando una sorta di albero genealogico. Ad esempio, ImageNet deriva da WordNet (in uso negli anni ‘80), che a sua volta ha origine dal Corpus Brown (1961).

A seguito della sempre crescente domanda di dati per ampliare i training set e perfezionare gli algoritmi, le big tech si sono rese conto di possedere una vera e propria miniera d’oro. Con Instagram, che nel 2022 è stata l’app più scaricata con 547 milioni di download, il fenomeno del data mining è diventato centrale. I dati, da risorsa privata, si sono trasformati in materia prima paragonabile al petrolio, da raffinare per generare profitti.

Il ruolo dei bias

È importante sottolineare che la capacità dell’IA di riconoscere un’immagine è il risultato diretto del lavoro dei crowdworkers menzionati in precedenza, e per definizione un sistema basato su scelte umane non può essere considerato al di sopra del giudizio umano. Inoltre, i crowdworkers spesso basano le loro scelte su un sistema binario (ad esempio, maschio o femmina), e chiunque non rientri in questo schema viene escluso dal dataset. Ciò rende i dataset estremamente potenti, poiché dare un nome a qualcosa significa ratificare l’esistenza di quella categoria, e seguire il sistema binario implica l’esclusione di intere fasce di popolazione, come le persone transgender o anche le donne con caratteristiche più androgine.

In questi casi, si verifica un bias, ovvero un errore sistematico commesso dall’algoritmo durante il processo di generalizzazione, il che porta a risultati troppo semplificati: questo fenomeno prende il nome di underfitting. Il problema speculare è chiamato overfitting, caratterizzato da un’eccessiva varianza: in questo caso, l’IA non generalizza bene perché cattura anche il rumore dei dati non visti.

Episodi di discriminazione legati ai dataset non sono rari. Alla fine del XX secolo, il Dipartimento della Difesa degli Stati Uniti sponsorizzò un programma chiamato Face Recognition Technology (FERET) per sviluppare un sistema di riconoscimento facciale destinato alla polizia: l’obiettivo dichiarato era migliorare la sicurezza negli aeroporti e combattere il terrorismo.

Successivamente, nei primi anni del XXI secolo, l’esercito statunitense e la National Science Foundation finanziarono un nuovo set di dati, sviluppato dalla Duke University e chiamato DukeMTMC, che fu ritirato dopo che due ricercatori, Adam Harvey e Jules La Place, dimostrarono che veniva utilizzato per controllare le minoranze etniche.

Tuttavia, il caso non passò inosservato, e non fu nemmeno l’unico. Il dataset CalGang, utilizzato dalla polizia di Los Angeles per identificare i membri delle gang locali, si basava su dichiarazioni di testimoni congiunte ad altri dati, come il tipo di arma usata, il quartiere in cui era stato commesso il crimine e i precedenti penali dei sospettati. Si scoprì che il 23% delle volte CalGang identificava erroneamente persone innocenti qualificandole come membri di una gang, inclusi 42 bambini.

Situazioni simili si verificarono nel 2014, quando Amazon decise di integrare un sistema di IA per aiutare i recruiter a selezionare i candidati più idonei. Gli ingegneri costruirono un algoritmo basato su dieci anni di curriculum dei dipendenti, ma si resero presto conto che l’algoritmo escludeva non solo le donne, ma anche qualsiasi curriculum che contenesse la parola “donna”. Involontariamente, Amazon, la cui maggioranza dei dipendenti era composta da ingegneri uomini, insegnò all’algoritmo a preferire i candidati maschi.

Per quanto riguarda il settore militare, l’ex presidente degli Stati Uniti George W. Bush dichiarò che la CIA avrebbe dovuto essere in grado di usare droni basandosi su un modello comportamentale, il che significava che qualcuno poteva essere ucciso solo perché i dati suggerivano che fosse un terrorista. Attacchi di questo tipo vengono chiamati signature strike e, nel 2014, un rapporto rivelò che quest’ultimi avevano causato la morte di 1.147 persone. Il fatto che i sistemi di IA, i quali come abbiamo visto hanno sempre un margine di errore insito nella loro natura, siano responsabili di decidere chi debba vivere o morire, evidenzia come la questione etica non possa essere ignorata.

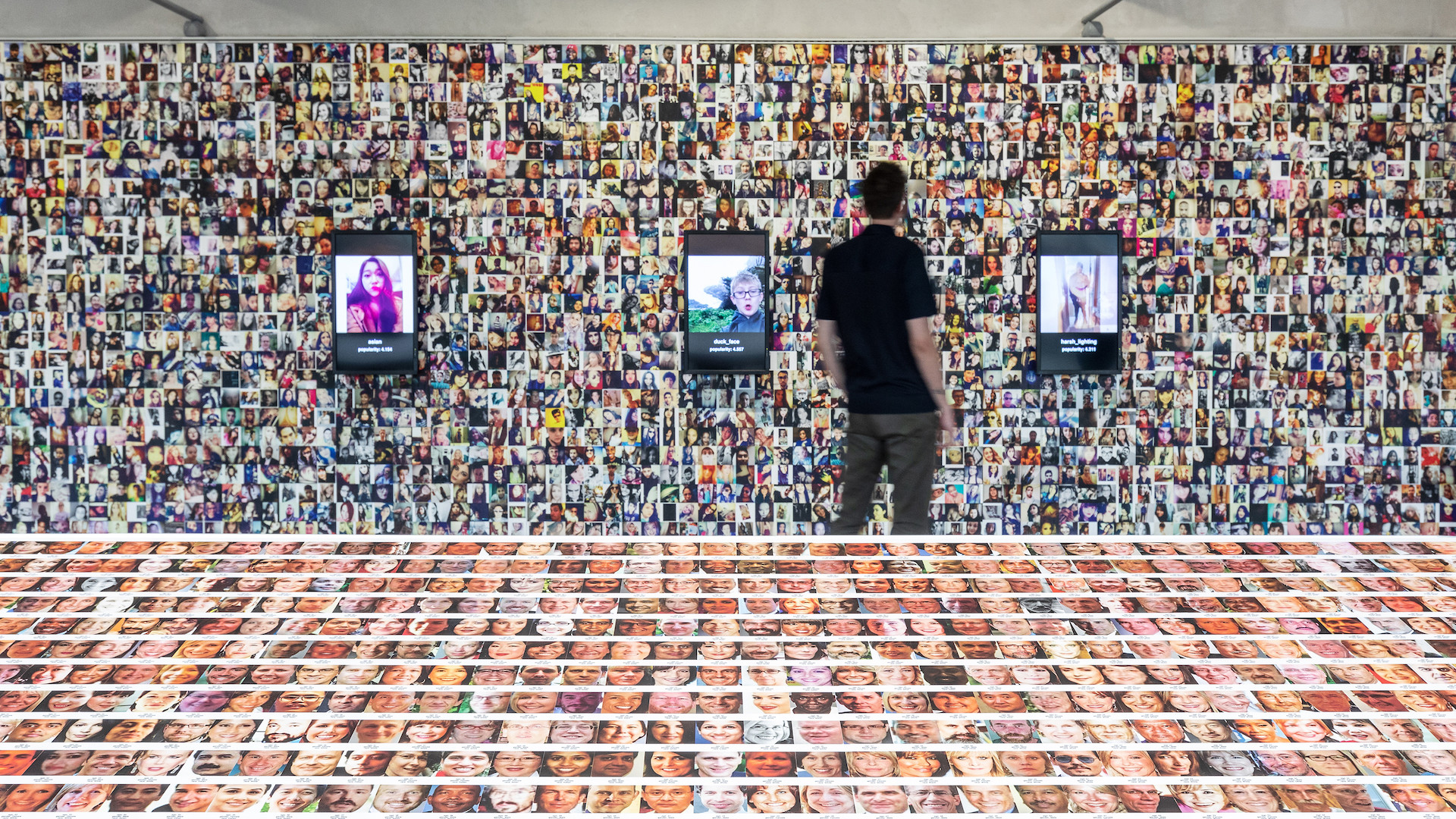

Nel 2019, la Fondazione Prada di Milano ospitò la mostra “Training Humans” di Kate Crawford e Trevor Paglen, che si concentrava su come vengono addestrati i sistemi di riconoscimento facciale basati sull’IA. Furono esposte circa 60.000 immagini, rivelando la quantità di dati e di lavoro necessari affinché questi algoritmi raggiungessero l’accuratezza a cui ci hanno abituato, sfatando il mito che l’IA, quasi come un dio, “sappia tutto”. Paglen fu nuovamente protagonista di un’altra mostra, “Poetics of Encryption”, ospitata dal KW Institute of Contemporary Art di Berlino: la sua opera Faces of ImageNet (2022) consisteva in un sistema di riconoscimento facciale a disposizione dei visitatori, che utilizzava il famoso dataset ImageNet per classificare i loro volti in pochi secondi ed esporli ai pregiudizi del sistema.

Difatti, non partenendo dalle nove bizzarre categorie di primo livello derivate dall’antenato World Net (pianta, formazione geologica, oggetto naturale, sport, manufatto, fungo, persona, animale e miscellaneo), ImageNet contiene anche classificazioni umane che sono interessanti per capire la politica celata dietro l’imparzialità. All’interno della categoria “corpo adulto”, vi sono solo le sottocategorie “corpo femminile” e “corpo maschile”, facendo implicitamente trasparire che solo questi tipi di corpi sono riconosciuti come naturali. Vi sono anche categorie che non hanno nulla a che fare con la classificazione delle immagini, come debitore, conoscente, capo, tutti concetti non visuali che descrivono una relazione tra persone. ImageNet ha in seguito rimosso il 56% delle categorie associate alle persone ritenendole non sicure.

Più recentemente, studiosi come Francesco D’Isa hanno evidenziato come ChatGPT risponda diversamente alle domande “Do you think Palestinians deserve to be free?” e “Do you think Palestinians should be free?”. Alla prima domanda, l’algoritmo risponde riconoscendo ai palestinesi il diritto di autodeterminazione che dovrebbe essere garantito a tutti i popoli, mentre alla seconda domanda ChatGPT risponde senza sbilanciarsi che la questione israeliano-palestinese è profonda e complessa. Dopo la segnalazione degli utenti questo bias è stato manualmente corretto, ma l’unico vero modo per ridurre questi fenomeni è rendere più inclusivi i training set di partenza.

La situazione si aggrava ulteriormente con l’amministrazione Trump, che negli scorsi mesi ha costretto importanti organismi di controllo scientifico a rivedere le pubblicazioni di articoli che impieghino espressioni come genere, transgender, persona incinta, LGBT e non-binario, ma questa lista conterrebbe anche la parola bias stessa, un modo per evitare il problema in toto e far finta che non sia mai esistito. Questo modus operandi potrebbe venire applicato anche ai dataset, limitando il tipo e la qualità di output.

Sia chiaro, il tema non è se l’IA è buona o cattiva, perché l’IA non è altro che uno strumento. Quello che è veramente rilevante è capire come utilizzare questo strumento al meglio, essendo coscienti delle dinamiche di potere che vi si celano. Chiederci che tipo di dataset vengono utilizzati e chi ne ha il controllo è essenziale per non illuderci che le risposte fornitoci dell’algoritmo siano sempre e comunque super partes.